High Performance Computing (HPC)

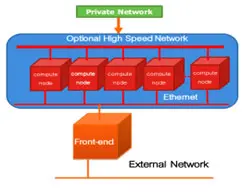

การคํานวณประสิทธิภาพสูง คือ ความสามารถในการประมวลผลข้อมูลและดําเนินการคํานวณที่ซับซ้อนด้วยความเร็วสูง หนึ่งในโซลูชัน HPC ที่รู้จักกันดีที่สุดคือซูเปอร์คอมพิวเตอร์ ซูเปอร์คอมพิวเตอร์มีโหนดประมวลผลจำนวนหลายโหนด (Node) ที่ทํางานร่วมกันเพื่อทํางานอย่างน้อยหนึ่งงานให้เสร็จ สิ่งนี้เรียกว่าการประมวลผลแบบขนาน มันคล้ายกับการรวม PC หลายพันเครื่องในเครือข่ายเข้าด้วยกัน รวมพลังการประมวลผลเพื่อทํางานให้เสร็จเร็วขึ้น

เมื่อเทคโนโลยีอย่างปัญญาประดิษฐ์ (AI) การจำลองภาพ 3D พัฒนาขึ้น ขนาดและปริมาณข้อมูลที่องค์กรต้องทํางานด้วยจึงเพิ่มขึ้นอย่างทวีคูณ เพื่อวัตถุประสงค์หลายประการ เช่น Computational solution / Chemistry / Physic / Bioinformatics / การป้องกันภัยพิบัติ / การพยากรณ์อากาศ / การสร้างสรรค์ผลิตภัณฑ์ใหม่ หรือ การวิเคราะห์แนวโน้มของตลาดหุ้น ความสามารถในการประมวลผลข้อมูลแบบเรียลไทม์จึงเป็นสิ่งสําคัญ องค์กรต่างๆ จึงต้องการโครงสร้างพื้นฐานด้านไอทีที่รวดเร็วและเชื่อถือได้ในการประมวลผล จัดเก็บ และวิเคราะห์ข้อมูลที่มีจํานวนมหาศาล

Artificial Intelligent (AI)

ปัญญาประดิษฐ์ หรือ AI คือการจําลองกระบวนการทางปัญญาของมนุษย์โดยเครื่องจักร โดยเฉพาะระบบคอมพิวเตอร์ การใช้งานเฉพาะของ AI ได้แก่ ระบบผู้เชี่ยวชาญ การประมวลผลภาษาธรรมชาติ การรู้จําเสียงพูด และระบบภาพโดยทั่วไป ระบบ AI ทํางานโดยการนําเข้าข้อมูลการฝึกอบรมจํานวนมาก วิเคราะห์ข้อมูลสําหรับความสัมพันธ์และรูปแบบ และใช้รูปแบบเหล่านี้เพื่อคาดการณ์เกี่ยวกับสถานะในอนาคต ด้วยวิธีนี้ ตัวอย่างข้อความสามารถเรียนรู้เพื่อสร้างการแลกเปลี่ยนกับผู้คนที่สมจริง หรือเครื่องมือจดจํารูปภาพสามารถเรียนรู้ที่จะระบุและอธิบายวัตถุในรูปภาพโดยการตรวจสอบตัวอย่างนับล้าน เทคนิค AI แบบใหม่ที่ปรับปรุงอย่างรวดเร็วสามารถสร้างข้อความ รูปภาพ เพลง และสื่ออื่นๆ ที่เหมือนจริงได้

Big Data

ข้อมูลขนาดใหญ่หมายถึงชุดข้อมูลที่มีขนาดใหญ่หรือซับซ้อนเกินกว่าที่จะจัดการโดยซอฟต์แวร์แอปพลิเคชันแบบดั้งเดิม ข้อมูลที่มีรายการจํานวนมาก ข้อมูลที่ซับซ้อนมากขึ้น อาจนําไปสู่ความผิดพลาดในการวิเคราะห์และนำมาใช้งานที่สูงขึ้น ความท้าทายในการวิเคราะห์ข้อมูลขนาดใหญ่ ได้แก่ การเก็บข้อมูล การจัดเก็บข้อมูล การวิเคราะห์ข้อมูล การค้นหา การแบ่งปัน การถ่ายโอน การแสดงภาพ การสืบค้น การอัปเดต ความเป็นส่วนตัวของข้อมูล และแหล่งข้อมูล

Big Data จึงจำเป็นต้องให้ความสำคัญในด้านความถูกต้องและคุณภาพของข้อมูล หากไม่มีการลงทุนที่เพียงพอและไม่มีความเชี่ยวชาญสําหรับ Big Data ปริมาณและความหลากหลายของข้อมูลสามารถสร้างต้นทุนและความเสี่ยงที่จะเกิดขึ้นให้กับองค์กรได้

ปัจจุบันโลกขับเคลื่อนด้วยข้อมูลปริมาณมหาศาลจะมีอยู่เทคโนโลยีที่ใช้ในการประมวลผล Big Data อยู่ 2 เทคโนโลยีหลักคือ

1. HPC หรือ High-Performance Computing เป็นเทคโนโลยีเพื่อการคำนวณและประมวลผลด้วยความเร็วสูง ซึ่งโครงการที่ใช้การประมวลผลระดับสูงนั้นต้องใช้ทรัพยากรในการคำนวณขั้นสูง ประมวลผล วิเคราะห์ และสร้างแบบจำลองที่แม่นยำสมจริง

2. Cloud หรือ เทคโนโลยี HPC Cloud computing ซึ่งเกิดมาเพื่อการทำงานคำนวณและประมวลผล Big data เช่นเดียวกับ HPC

สนใจสอบถามข้อมูล HPC/ AI / Big Data ติดต่อฝ่ายขาย 083 963 2555